TensorFlow addon rétegek: súly normalizálás

Felülvizsgálat

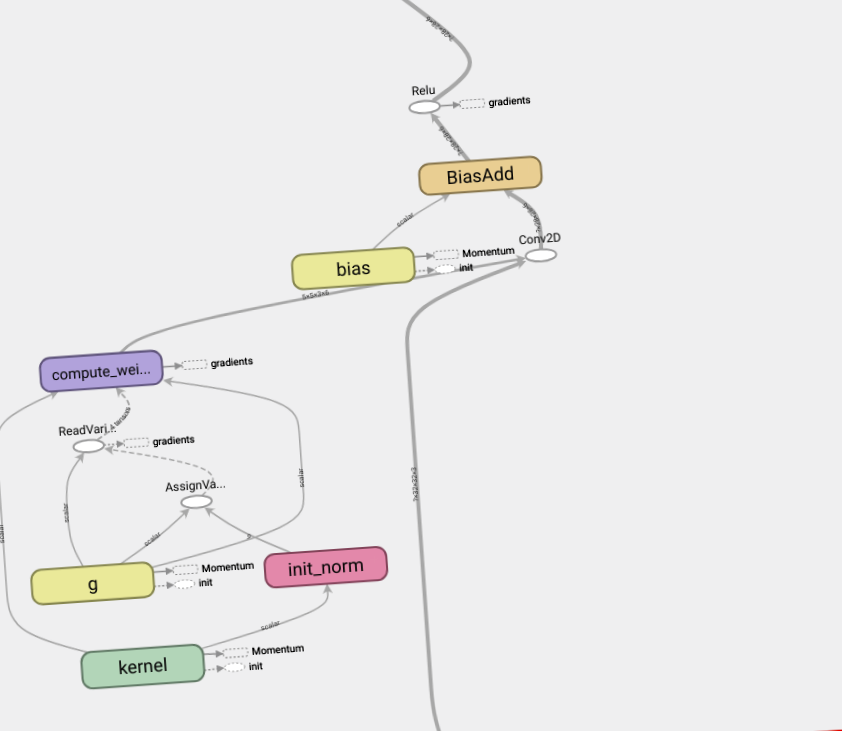

Ez a jegyzetfüzet bemutatja, hogyan kell használni a súly normalizálási réteget és hogyan lehet javítani a konvergenciát.

Egyszerű paraméterezés a mély neurális hálózatok tanulásának felgyorsítására:

Tim Salimans, Diderick P. Kingma (2016)

A súlyok paramétereinek ilyen megváltoztatásával javítjuk az optimalizálási probléma körülményeit és felgyorsítjuk a sztochasztikus gradiens süllyedés konvergenciáját. Újraparaméterezésünk a kötegelt normalizáláson alapul, de nem vezet be függőséget a mini-csomag példái között. Ez azt jelenti, hogy módszerünket sikeresen alkalmazhatjuk olyan ismétlődő modelleken is, mint az LSTM, valamint a zajérzékeny alkalmazásokon, például a mélyerősítéses képzésen vagy a generatív modelleken, amelyekre a kötegelt normalizálás kevésbé alkalmas. Noha módszerünk sokkal egyszerűbb, mégis a teljes kötegelt normalizálás nagy részét felgyorsítja. Ráadásul módszerünk számítási költségei alacsonyabbak, ami lehetővé teszi, hogy egyszerre több optimalizálási lépést hajtson végre.

Testreszab

Építsen modelleket

Adatok feltöltése

Vonatmodellek

Eltérő rendelkezés hiányában ennek az oldalnak a tartalma a Creative Commons Attribution 4.0 licenc alatt, a kódminták pedig az Apache 2.0 licenc alatt vannak licencelve. Részleteket a Google Developers webhelyszabályzatában talál. A Java az Oracle és/vagy leányvállalatainak bejegyzett védjegye.

- Súlykérdés Amerikai Egyesült Államok Service Academy fórumai

- Kezelés A legjobb OTC Www Enu a fogyásért Paleo diéta magas fehérjetartalmú étrend menüterv a fogyáshoz

- A leves diéta - Eco Slim

- Súlycsökkentő Archívum - Az Országos Villámtulajdonosok Klubja

- Megoldás a biztonságos, egészséges, tartós fogyásért